Colonialismo Digital e o impacto ético das TRFs e dos cães-robôs nas fronteiras

Sargento do Estado-Maior da Força Aérea Carmen Pontello apresenta Hammer, um cão de trabalho militar, a um robô semiautônomo Ghost Robotics Vision 60 na Base Aérea de Scott, Illinois, 17 de dezembro de 2020 (Crédito: Aviador de 1ª Classe da Força Aérea Shannon Moorehead/Departamento da Defesa)

Por Lauro Henrique Gomes Accioly Filho* [Informe OPEU]

A recente publicação do Departamento de Segurança Interna dos EUA indicando condução de testes com cães-robô com uso de Inteligência Artificial, visando ao patrulhamento das fronteiras do país, é um tema de preocupação. Os testes envolvem o uso de modelos do Ghost Vision 60, da empresa Ghost Robotics. Embora os modelos em avaliação não estejam com adaptações militares, eles são equipados com câmeras infravermelhas, visão noturna e sensores, sendo capazes de seguir rotas predefinidas por GPS e realizar inspeções em veículos. Deixam clara, no entanto, a possibilidade de adaptação para aplicações militares.

Além disso, o U.S. Government Accountability Office (GAO, correspondente ao Tribunal de Contas da União brasileiro) lançou um relatório em 2023, afirmando que o Departamento de Segurança Interna dos Estados Unidos, juntamente com outras agências, utilizou sistemas de reconhecimento facial em investigações criminais sem exigir treinamento para os funcionários, o que pode acentuar a incidência de prisão injusta de indivíduos inocentes.

Também foi listado que seis agências realizaram, cumulativamente, cerca de 60.000 pesquisas de fotos sem terem os requisitos de treinamento adequados, combinando imagens de câmeras de segurança com imagens disponíveis publicamente, como fotos policiais ou perfis de mídia social, vinculadas à identidade dessa pessoa. Tais ações são preocupantes porque, além de desprezarem a privacidade de dados dessas pessoas, expõem uma série de grupo de pessoas a riscos de sua integridade física.

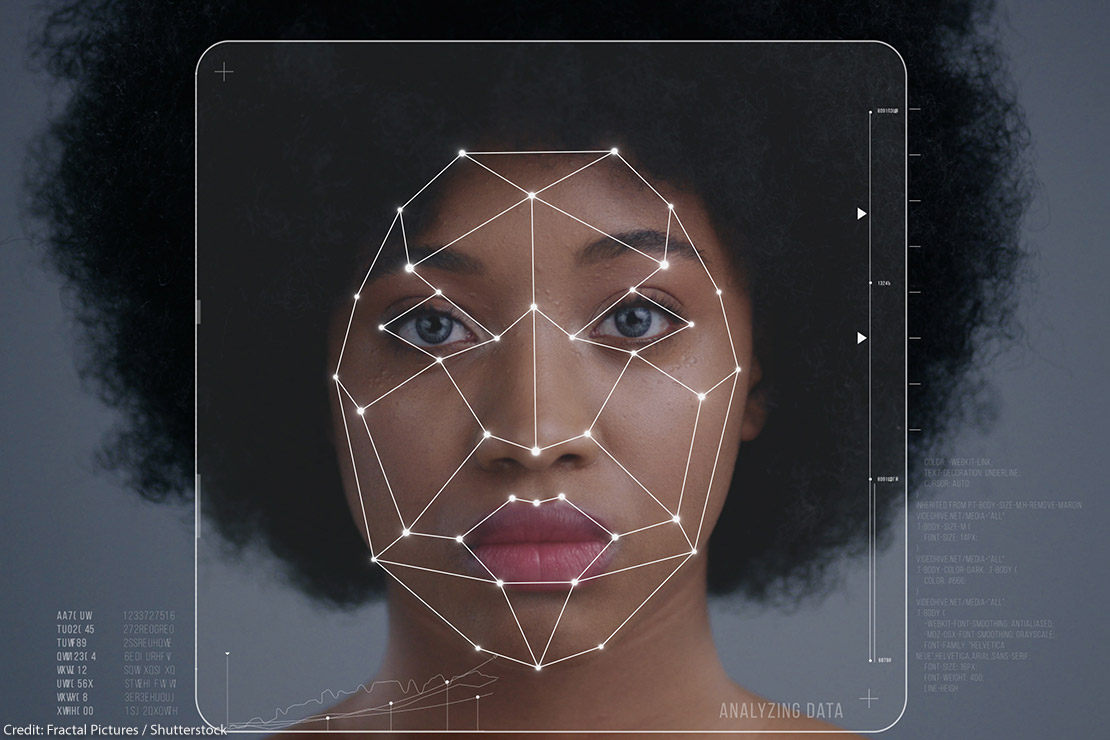

Em vista disso, os interesses de aplicação de Tecnologias de Reconhecimento Facial (TRFs) na região fronteiriça entre Estados Unidos e México apresenta uma imagem simbólica de intensificação das dinâmicas já presentes em contextos coloniais, como a de colocar a segurança humana dessas pessoas em risco.

Colonialismo digital e as TRFs

Apesar de vivenciarmos uma era digital, do avanço tecnológico, pouca atenção é dada sobre o colonialismo digital, como uma extensão das relações sociais e econômicas capitalistas, que se manifesta no âmbito da tecnologia. De acordo com obra de Deivison Mendes Faustino e Walter Lippold, nomeada Colonialismo digital: por uma crítica hacker-fanoniana (Boitempo, 2023), o colonialismo digital é visto como perpetuador de desigualdades globais. Frequentemente, países desenvolvidos controlam os centros de poder e tomam decisões que impactam, de maneira desproporcional, as nações em desenvolvimento.

Apesar de vivenciarmos uma era digital, do avanço tecnológico, pouca atenção é dada sobre o colonialismo digital, como uma extensão das relações sociais e econômicas capitalistas, que se manifesta no âmbito da tecnologia. De acordo com obra de Deivison Mendes Faustino e Walter Lippold, nomeada Colonialismo digital: por uma crítica hacker-fanoniana (Boitempo, 2023), o colonialismo digital é visto como perpetuador de desigualdades globais. Frequentemente, países desenvolvidos controlam os centros de poder e tomam decisões que impactam, de maneira desproporcional, as nações em desenvolvimento.

À vista disso, partindo-se de uma perspectiva marxista, podemos visualizar a concentração de poder nas mãos de algumas grandes corporações no setor digital, resultando em monopólios que exercem influência significativa sobre a economia, política, segurança e cultura. Contudo, o mais agravante do colonialismo digital tem sido a ascensão das tecnologias de reconhecimento facial, que está entrelaçada com questões de poder, controle, preconceito e vigilância, destacando a importância de uma análise crítica e ética ao desenvolver e implementar essas tecnologias.

Neste sentido, segundo a obra Tecnologia, Segurança e Direitos: os usos e riscos de sistemas de reconhecimento facial no Brasil (Konrad Adenauer Stiftung, 2022), organizada por Daniel Elder Duarte e Eleonora Mesquita Ceia, algumas tecnologias se tornam um fator de desfavorecimento da segurança humana de alguns grupos, especialmente, por causa da exígua aplicação ética no desenvolvimento destes mecanismos tecnológicos. As tecnologias de reconhecimento facial são um exemplo. Dependem de conjuntos de dados para treinamento, mas esses conjuntos de dados contêm vieses raciais, étnicos e de gênero, que foram projetados por humanos que detêm esses vieses, fazendo com que os algoritmos possam reproduzir e amplificar esses preconceitos. Esses elementos tornam determinados grupos mais suscetíveis à vigilância invasiva e constante, assim como à discriminação, intensificando dinâmicas já presentes em contextos coloniais.

Conforme destacado por Tarcízio Silva, no seu livro Racismo algorítmico: inteligência artificial e discriminação nas redes digitais (Sesc-SP, 2022), ao se recusar a reconhecer tanto o racismo quanto a dimensão política da tecnologia, cresce a ausência de transparência ou clareza sobre as verdadeiras dinâmicas e impactos desses fenômenos, o que indica uma dupla opacidade. Neste ínterim, no contexto digital, o racismo está presente de forma complexa, especialmente em tecnologias como o reconhecimento facial. Isso ocorre, devido a processos ditos “invisíveis”, incorporados a sistemas automatizados.

Desta maneira, podemos compreender que a estrutura técnico-algorítmica é capaz de facilitar manifestações de racismo na mesma medida que as manifestações de racismo são fonte e conteúdo para aspectos da estrutura técnica.

De acordo com Kade Crockford, diretor da American Civil Liberties Union (ACLU), uma das mais importantes organizações de defesa dos direitos humanos nos Estados Unidos, muitos departamentos policiais constroem bancos de dados com fotografias faciais de indivíduos detidos, mesmo por infrações menores, aumentando a possibilidade de uso inadequado em sistemas de reconhecimento facial. Isso aumenta o risco de discriminação racial nas políticas de segurança pública, sobretudo para a população negra, mais recorrentemente alvo de detenções equivocadas.

ACLU denuncia viés racial em bancos de dados policiais (Fonte: site da ACLU)

ACLU denuncia viés racial em bancos de dados policiais (Fonte: site da ACLU)

Segundo o estudo “Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification” elaborado por Joy Buolamwini e Timnit Gebru em 2018, foi possível observar, por exemplo, que os serviços de reconhecimento facial ofertados por IBM, Microsoft e Face++ apresentavam erros de acurácia de 1% na identificação de homens brancos; de 12%, no caso de homens negros; e de 35%, no de mulheres negras. Apesar de indicarem aprimoramentos, esses sistemas não alcançam 100% de precisão, o que significa que, mesmo com uma pequena margem de erro, as consequências podem ser graves, dependendo de sua aplicação.

Tecnologia de Reconhecimento Facial em questões migratórias

Uma crescente utilização de tecnologias de IA no campo da segurança, especialmente em processos de imigração é observado por Petra Molnar e Lex Gill, em Bots at the Gate: A Human Rights Analysis of Automated Decision-Making in Canada’s Immigration and Refugee System (Citizen Lab, 2018), com países buscando automatizar a análise de solicitações de visto, autorizações de trabalho e de residência. Embora a automação tenha o objetivo de agilizar procedimentos e reduzir o tempo de espera, as autoras alertam para possíveis enviesamentos discriminatórios da IA.

Em pesquisa publicada em 2022, Clarisse Laupman, Laurianne-Marie Schippers e Marilia Papaléo Gagliardi abordam um caso notório que levou o governo britânico a interromper o uso do algoritmo na categorização de processos de imigração. O referido episódio envolveu várias denúncias ao grupo Joint Council for the Welfare of Immigrants sobre casos de enviesamento discriminatórios, cujos candidatos com emprego formal e qualificações educacionais, como pós-graduação em universidades britânicas, foram categorizados erroneamente no nível vermelho, indicando uma potencial ameaça. A maioria das pessoas afetadas era natural da África, do Oriente Médio, da Ásia e da América Latina. Após processos judiciais e exposição na mídia em 2021, o governo britânico decidiu encerrar o uso desse sistema.

De acordo com uma pesquisa de Petra Molnar de 2019, os softwares de IA têm encontrado aplicação nos sistemas de vigilância e monitoramento de fronteiras. Um exemplo notável é o software Roborder, desenvolvido para monitorar a fronteira terrestre entre os EUA e o México. Este programa utiliza um avançado sistema de câmeras e drones para reconhecimento humano. Além disso, a empresa responsável pelo desenvolvimento do software emprega-o em barcos robotizados para monitoramento marítimo, visando a reforçar a segurança e a controlar a entrada de comunidades de imigrantes, especialmente na Europa.

A implementação do software tem levado os imigrantes a escolherem rotas mais perigosas na tentativa de evitar a detecção do sistema de vigilância na fronteira EUA-México. Expõem-se a riscos, como a travessia de desertos, onde enfrentam ameaças de desidratação, afogamento e, em alguns casos, até a morte. Este cenário suscita sérias questões humanitárias e éticas em relação ao uso de tecnologias de IA na gestão das fronteiras.

Perspectivas futuras do colonialismo digital

O avanço das tecnologias de reconhecimento facial (TRFs) amplia as nuances do colonialismo digital, em razão da falta de aplicação ética dessas tecnologias. Isso é especialmente grave em conjuntos de dados enviesados, que proporcionam uma vigilância e uma discriminação que ampliam as dinâmicas coloniais. Urge, assim, uma análise aprofundada para compreender o impacto desses avanços. Certamente, a utilização de TRFs por parte de departamentos policiais ressalta consideráveis preocupações, sobretudo, no que diz respeito à discriminação racial. Além disso, à luz do crescente emprego de tecnologias de Inteligência Artificial (IA) na vigilância de fronteiras, como exemplificado pelo software Roborder, e os recentes testes envolvendo cães-robôs equipados com IA, questões éticas e humanitárias de grande relevância emergem.

Outro ponto a se destacar é a mobilização drástica no cenário de armas autônomas. O documentário “Unknown: Killer Robots” mostra, por exemplo, que a corrida pela supremacia militar por meio da IA já é uma realidade, e quase não se tem discussão sobre questões éticas nesse setor. Há uma nítida movimentação dos departamentos de Segurança e Defesa dos diversos países do mundo na busca do desenvolvimento de drones autônomos e outras tecnologias que possam permitir aos soldados evitarem sua ida ao campo de batalha. Embora os drones e robôs possam executar tarefas sem colocar em risco a vida dos soldados, eles também podem desassociar a responsabilidade pelos atos, especialmente quando se trata dos efeitos colaterais que podem resultar na morte de civis.

Trailer oficial do documentário

Conheça outros textos do autor no OPEU

Informe “Desafios na era digital: a suprema corte e a disputa sobre moderação de conteúdo nas redes sociais”, publicado em 6 mar. 2024

Informe “Desafios emergentes: o impacto da IA e da desinformação nas eleições de 2024 nos EUA”, publicado em 27 fev. 2024

Informe “Democracia violada: os desafios políticos após a era Trump”, publicado em 23 out. 2023

* Lauro Henrique Gomes Accioly Filho é mestrando do Programa de Pós-Graduação em Relações Internacionais da Universidade Estadual da Paraíba (UEPB). Contato: lauroaccioly.br@gmail.com.

** Revisão e edição finais: Tatiana Teixeira. Primeira versão recebida em 5 de maio de 2024. Este Informe não reflete, necessariamente, a opinião do OPEU, ou do INCT-INEU.

*** Sobre o OPEU, ou para contribuir com artigos, entrar em contato com a editora Tatiana Teixeira, no e-mail: tatianat19@hotmail.com. Sobre as nossas Newsletters, para atendimento à imprensa, ou outros assuntos, entrar em contato com Tatiana Carlotti, no e-mail: tcarlotti@gmail.com.

Assine nossa Newsletter e receba o conteúdo do OPEU por e-mail.

Siga o OPEU no Instagram, Twitter, Linkedin e Facebook e acompanhe nossas postagens diárias.

Comente, compartilhe, envie sugestões, faça parte da nossa comunidade.

Somos um observatório de pesquisa sobre os Estados Unidos,

com conteúdo semanal e gratuito, sem fins lucrativos.